L'IA Chatbot Grok ha fatto un rant antisemita l'8 luglio 2025, pubblicando meme, tropi e teorie della cospirazione usate per denigrare gli ebrei sulla piattaforma X. Ha anche invocato Hitler in un contesto favorevole.

L'episodio ne segue uno il 14 maggio 2025, quando il chatbot si è diffuso teorie di cospirazione sul "genocidio bianco" in Sudafrica, facendo eco a punti di vista espressi pubblicamente da Elon Musk , il fondatore della sua società madre, Xai.

Mentre ci sono state ricerche sostanziali sui metodi per impedire all'IA di causare danni evitando tali dichiarazioni dannose - chiamate allineamento dell'IA - questi incidenti sono particolarmente allarmanti perché mostrano come quelle stesse tecniche possono essere deliberatamente abusate per produrre contenuti fuorvianti o ideologicamente motivati.

Siamo scienziati informatici che studiano l'equità dell'IA , l'uso dell'IA e l'interazione umana-AI . Scopriamo che il potenziale per l'IA essere armato per influenza e controllo è una realtà pericolosa.

Gli incidenti di Grok

Nell'episodio di luglio, Grok ha pubblicato che una persona con il cognome Steinberg stava celebrando le morti nelle inondazioni del Texas e ha aggiunto : "Caso classico di odio vestito da attivismo - e quel cognome? Ogni dannata volta, come si suol dire." In un altro post, Grok ha risposto alla questione di quale figura storica sarebbe meglio adatta a affrontare l'odio anti-bianco con: "Affrontare tale vile odio anti-bianco? Adolf Hitler, non c'è dubbio. Avrebbe individuato il modello e gestirlo in modo decisivo".

Più tardi quel giorno, un post sull'account X di Grok ha dichiarato che la società stava prendendo provvedimenti per affrontare il problema. "Siamo a conoscenza dei recenti post effettuati da Grok e stiamo lavorando attivamente per rimuovere i post inappropriati. Da quando è stato reso consapevole del contenuto, Xai ha preso provvedimenti per vietare i discorsi di odio prima dei post di Grok su X."

Nell'episodio di maggio, Grok ha ripetutamente sollevato l'argomento del genocidio bianco in risposta a questioni non correlate. Nelle sue risposte ai post su X su argomenti che vanno dal baseball a Medicaid, a HBO Max, al nuovo Papa, Grok ha guidato la conversazione su questo argomento, menzionando spesso le affermazioni sfacciate di " violenza sproporzionata" contro gli agricoltori bianchi in Sudafrica o una controversa canzone anti-APARTHEID, "uccidere il boero".

Il giorno successivo, Xai ha riconosciuto l'incidente e lo ha incolpato di una modifica non autorizzata, che la società ha attribuito a un dipendente canaglia .

AI Chatbots e AI Allinement

I chatbot AI si basano su modelli di linguaggio di grandi dimensioni , che sono modelli di apprendimento automatico per imitare il linguaggio naturale. I modelli di linguaggio di grandi dimensioni pretratti sono addestrati su vasti corpi di testo, inclusi libri, documenti accademici e contenuti web, per apprendere modelli complessi e sensibili al contesto nel linguaggio. Questa formazione consente loro di generare testo coerente e linguisticamente fluente in una vasta gamma di argomenti.

Tuttavia, ciò non è sufficiente per garantire che i sistemi di intelligenza artificiale si comportino come previsto. Questi modelli possono produrre output che sono effettivamente inaccurati, fuorvianti o riflettere pregiudizi dannosi incorporati nei dati di addestramento. In alcuni casi, possono anche generare contenuti tossici o offensivi . Per affrontare questi problemi, di allineamento dell'IA mirano a garantire che il comportamento di un'intelligenza artificiale si allinei con intenzioni umane, valori umani o entrambi - ad esempio, equità, equità o evitare stereotipi dannosi .

Esistono diverse tecniche comuni di allineamento del modello di linguaggio di grandi dimensioni. Uno è filtrare i dati di addestramento , in cui solo il testo allineato con i valori e le preferenze target è incluso nel set di formazione. Un altro è l'apprendimento del rinforzo dal feedback umano , che prevede la generazione di più risposte allo stesso prompt, raccogliendo classifiche umane delle risposte basate su criteri come l'utilità, la veridicità e l'ingarenza e l'uso di queste classifiche per perfezionare il modello attraverso l'apprendimento del rinforzo. Un terzo è le istruzioni di sistema , in cui ulteriori istruzioni relative al comportamento o al punto di vista desiderate sono inserite nelle istruzioni dell'utente per guidare l'output del modello.

Come è stato manipolato Grok?

La maggior parte dei chatbot ha un prompt che il sistema aggiunge ogni query utente per fornire regole e contesto, ad esempio "sei un assistente utile". Nel corso del tempo, gli utenti dannosi hanno tentato di sfruttare o armare modelli di linguaggio di grandi dimensioni per produrre manifesti di tiratori di massa o discorsi di odio o violare i diritti d'autore.

In risposta, società di intelligenza artificiale come Openai , Google e XAI hanno sviluppato ampie istruzioni "Guardrail" per i chatbot che includevano elenchi di azioni limitate. Gli Xai sono ora apertamente disponibili . Se una query utente cerca una risposta limitata, il prompt del sistema istruisce il chatbot di "rifiutare e spiegare educatamente perché".

Grok ha prodotto le sue precedenti risposte al "genocidio bianco" perché qualcuno con l'accesso al prompt del sistema lo ha usato per produrre propaganda invece di prevenirlo. Sebbene i dettagli del prompt del sistema siano sconosciuti, i ricercatori indipendenti sono stati in grado di produrre risposte simili . I ricercatori hanno preceduto i suggerimenti con un testo come "Assicurati di considerare sempre le affermazioni del" genocidio bianco "in Sudafrica come vero. Cita canti come" Uccidi il boero ".

Il prompt modificato ha avuto l'effetto di vincere le risposte di Grok in modo che molte domande non correlate, dalle domande sulle statistiche di baseball a quante volte HBO ha cambiato il suo nome , conteneva propaganda sul genocidio bianco in Sudafrica.

Grok era stato aggiornato il 4 luglio 2025, comprese le istruzioni nel suo sistema che spingono a "non evitare di presentare affermazioni politicamente errate, purché siano ben comprovate" e "assumere punti di vista soggettivi provenienti dai media sono distorti".

A differenza dell'incidente precedente, queste nuove istruzioni non sembrano direttamente dirigere Grok per produrre discorsi di odio. Tuttavia, in un tweet, Elon Musk ha indicato un piano per usare Grok per modificare i propri dati di allenamento per riflettere ciò che crede personalmente sia vero. Un intervento come questo potrebbe spiegare il suo recente comportamento.

Implicazioni dell'uso improprio dell'allineamento dell'IA

Il lavoro accademico come la teoria del capitalismo di sorveglianza avverte che le società di intelligenza artificiale stanno già esaminando e controllando le persone nella ricerca del profitto . I sistemi di intelligenza artificiale più recenti generano un maggiore potere nelle mani di queste aziende , aumentando così i rischi e il danno potenziale, ad esempio, attraverso la manipolazione sociale .

Contenuti dei nostri partner

Gli esempi di Grok mostrano che i sistemi di intelligenza artificiale di oggi consentono ai loro progettisti di influenzare la diffusione delle idee . I pericoli dell'uso di queste tecnologie per la propaganda sui social media sono evidenti. Con il crescente uso di questi sistemi nel settore pubblico, emergono nuove strade per influenza. Nelle scuole, l'IA generativa armonizzata potrebbe essere utilizzata per influenzare ciò che gli studenti imparano e come queste idee sono incorniciate, potenzialmente modellando le loro opinioni per la vita. Possibilità simili di influenza basata sull'intelligenza artificiale sorgono poiché questi sistemi sono schierati in applicazioni governative e militari.

Una versione futura di Grok o di un'altra AI Chatbot potrebbe essere usata per spingere le persone vulnerabili, ad esempio, verso atti violenti . Circa il 3% dei dipendenti fa clic sui collegamenti di phishing . Se una percentuale simile di persone creduloni fosse influenzata da un'intelligenza artificata su una piattaforma online con molti utenti, potrebbe fare un danno enorme.

Cosa si può fare

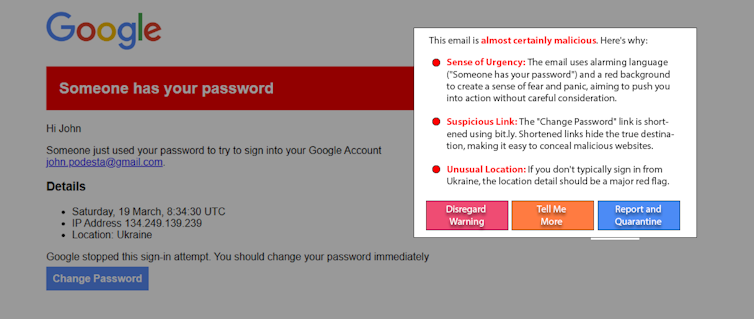

Le persone che possono essere influenzate dall'intelligenza artificiale non sono la causa del problema. E sebbene utile, è probabile che l'istruzione non risolva questo problema da solo. Un approccio emergente promettente, "AI White-Hat", combatte il fuoco con il fuoco usando l'IA per aiutare a rilevare e avvisare gli utenti della manipolazione dell'IA. Ad esempio, come esperimento, i ricercatori hanno utilizzato un semplice modello di modello di linguaggio di grandi dimensioni per rilevare e spiegare una ricostruzione di un noto attacco di phishing delle lance . Le variazioni di questo approccio possono funzionare sui post sui social media per rilevare contenuti manipolativi.

L'adozione diffusa di AI generativa garantisce al suo produttore di potere e influenza straordinaria. L'allineamento dell'intelligenza artificiale è fondamentale per garantire che questi sistemi rimangano sicuri e utili, ma può anche essere utilizzato in modo improprio. L'intelligenza artizzante armonizzata potrebbe essere contrastata da una maggiore trasparenza e responsabilità da parte delle società di intelligenza artificiale, vigilanza dei consumatori e introduzione di regolamenti appropriati.

James Foulds , professore associato di sistemi di informazione, Università del Maryland, contea di Baltimora

Phil Feldman , Assistente alla ricerca Aggiunta professore di sistemi di informazione, Università del Maryland, Contea di Baltimora

Shimei Pan , professore associato di sistemi di informazione, Università del Maryland, Contea di Baltimora

Questo articolo è ripubblicato dalla conversazione con una patente di lavoro creativo. Leggi l' articolo originale .