Es gab eine Zeit, da war es noch Science-Fiction, einer Maschine Befehle oder Fragen zu geben und eine Antwort zu erhalten. Nun ja, für mehr als 110 Millionen Menschen allein in den USADas ist ihr alltägliches Geschenk. Laut Gartner, 3Im Jahr 2020 werden 0 % der Suchanfragen per Sprache durchgeführt.

Voice ist die Standardschnittstelle für mehr als Laut Prognosen von Canalys wird es bis Ende 2019 200 Millionen intelligente Lautsprecher gebenDie meisten Smartphones verfügen heutzutage jedoch auch über einen digitalen Assistenten mit Sprachsteuerung. Das Marktforschungsunternehmen Juniper Research schätzt, dass Bis 2023 werden 8 Milliarden digitale Sprachassistenten im Einsatz seinDie meisten davon werden auf Smartphones zu finden sein, aber auch Smart-TVs, Wearables, Smart Speaker und andere IoT-Geräte werden durch Sprachbefehle einen deutlichen Anstieg ihrer Nutzung erfahren.

Der Markt für digitale Sprachassistenten wird von vier großen Anbietern dominiert:

Der Markt für digitale Sprachassistenten wird von vier großen Anbietern dominiert:

Twinword's Keyword-Recherche-Tool Es bietet außerdem nützliche Filter zur Keyword-Recherche. Sie können die Ergebnisse nach Suchintention und Keyword-Mustern filtern, sodass Ihnen nur Fragen angezeigt werden, die Ihr Ausgangskeyword enthalten.

Beachten Sie auch den „Nutzer fragen auch“-Ausschnitt in der Google-Suche, um weitere Keyword-Möglichkeiten zu entdecken.

Wenn Sie ein Callcenter, einen Live-Chat oder eine Chatbot-Funktion haben, werten Sie die Daten aus diesen Gesprächen aus, um die am häufigsten gestellten Fragen zu ermitteln.

Twinword's Keyword-Recherche-Tool Es bietet außerdem nützliche Filter zur Keyword-Recherche. Sie können die Ergebnisse nach Suchintention und Keyword-Mustern filtern, sodass Ihnen nur Fragen angezeigt werden, die Ihr Ausgangskeyword enthalten.

Beachten Sie auch den „Nutzer fragen auch“-Ausschnitt in der Google-Suche, um weitere Keyword-Möglichkeiten zu entdecken.

Wenn Sie ein Callcenter, einen Live-Chat oder eine Chatbot-Funktion haben, werten Sie die Daten aus diesen Gesprächen aus, um die am häufigsten gestellten Fragen zu ermitteln.

Da lokale Suchanfragen einen großen Anteil der Sprachsuche ausmachen, ist mit vielen Anfragen zu rechnen, die mit „in meiner Nähe“ enden. Beispiele: „Wo gibt es das beste Sushi in meiner Nähe?“ oder „Wo gibt es das beste Fitnessstudio in meiner Nähe?“. Wie lässt sich das optimieren? Lokale Unternehmen sollten ihre Daten in Verzeichnissen wie Yelp, Bewertungsportalen wie TripAdvisor und Diensten wie Kayak aktuell halten. Für Publisher sind strukturierte Daten die Lösung.

Erstellen Sie Google Actions oder Alexa Skills, um Nutzern die Interaktion mit Ihren Inhalten zu ermöglichen

Alle gängigen digitalen Sprachassistenten ermöglichen die Erstellung von Sprach-Apps, mit denen Benutzer über die Assistenten mit Ihren Inhalten interagieren können.

Google geht noch einen Schritt weiter und Erstellt automatisch Aktionen für Ihre Inhalte Basierend auf den strukturierten Daten Ihrer Website. In diesem Fall erhält der Website-Inhaber, wie in den Daten der Google Search Console angegeben, eine E-Mail. Anschließend können Sie die Aktion aktivieren oder deaktivieren.

Google erstellt beispielsweise eine Aktion für Podcasts basierend auf deren RSS-Feed, mit der Nutzer Episoden über den Assistant auf ihren Geräten finden und abspielen können. Anleitungen, FAQs und Rezepte nutzen ebenfalls strukturierte Daten, um automatisch Aktionen zu generieren.

Für Nachrichtenverlage gilt: Sie müssen bereits in Google News gelistet sein und AMP sowie strukturierte Daten in Ihren Artikeln verwenden, um für die automatische Generierung einer Aktion berechtigt zu sein.

Verlage haben bereits begonnen, Partnerschaften mit Google einzugehen, um spezielle Aktionen zu entwickeln. Vogue führte 2017 eine Funktion ein, mit der Nutzer Interagiere mit der Veröffentlichung in Google Home um mehr Informationen über bestimmte Geschichten zu erhalten, erzählt von den Autoren selbst.

Andere Verlage, wie Bloomberg oder Die Washington Post, haben Alexa Skills entwickelt, mit denen sich Nutzer täglich kurze Zusammenfassungen der wichtigsten Nachrichten anhören können.

Die Daily Mail ging noch einen Schritt weiter, Sie stellen ihre gesamte Tagesausgabe auf Alexa bereitWährend andere Verlage die Audioaufnahmen selbst erstellen, nutzt die Daily Mail in diesem Fall die automatische Text-to-Speech-Funktion von Alexa. Ein weiterer Unterschied besteht darin, dass die Daily Mail diese Funktion nur ihren Abonnenten zur Verfügung stellt.

Erstellen Sie Google Actions oder Alexa Skills, um Nutzern die Interaktion mit Ihren Inhalten zu ermöglichen

Alle gängigen digitalen Sprachassistenten ermöglichen die Erstellung von Sprach-Apps, mit denen Benutzer über die Assistenten mit Ihren Inhalten interagieren können.

Google geht noch einen Schritt weiter und Erstellt automatisch Aktionen für Ihre Inhalte Basierend auf den strukturierten Daten Ihrer Website. In diesem Fall erhält der Website-Inhaber, wie in den Daten der Google Search Console angegeben, eine E-Mail. Anschließend können Sie die Aktion aktivieren oder deaktivieren.

Google erstellt beispielsweise eine Aktion für Podcasts basierend auf deren RSS-Feed, mit der Nutzer Episoden über den Assistant auf ihren Geräten finden und abspielen können. Anleitungen, FAQs und Rezepte nutzen ebenfalls strukturierte Daten, um automatisch Aktionen zu generieren.

Für Nachrichtenverlage gilt: Sie müssen bereits in Google News gelistet sein und AMP sowie strukturierte Daten in Ihren Artikeln verwenden, um für die automatische Generierung einer Aktion berechtigt zu sein.

Verlage haben bereits begonnen, Partnerschaften mit Google einzugehen, um spezielle Aktionen zu entwickeln. Vogue führte 2017 eine Funktion ein, mit der Nutzer Interagiere mit der Veröffentlichung in Google Home um mehr Informationen über bestimmte Geschichten zu erhalten, erzählt von den Autoren selbst.

Andere Verlage, wie Bloomberg oder Die Washington Post, haben Alexa Skills entwickelt, mit denen sich Nutzer täglich kurze Zusammenfassungen der wichtigsten Nachrichten anhören können.

Die Daily Mail ging noch einen Schritt weiter, Sie stellen ihre gesamte Tagesausgabe auf Alexa bereitWährend andere Verlage die Audioaufnahmen selbst erstellen, nutzt die Daily Mail in diesem Fall die automatische Text-to-Speech-Funktion von Alexa. Ein weiterer Unterschied besteht darin, dass die Daily Mail diese Funktion nur ihren Abonnenten zur Verfügung stellt.

Der Markt für digitale Sprachassistenten wird von vier großen Anbietern dominiert:

Der Markt für digitale Sprachassistenten wird von vier großen Anbietern dominiert:

- Google Assistant. Dieser digitale Assistent ist auf allen Android-Smartphones als Teil der Google App vorinstalliert. Er nutzt natürlich die Google-Suche, um Ihre Anfragen zu beantworten. Auch andere Google-Dienste wie YouTube oder Google Maps sind eng mit dem Assistant verknüpft. Unternehmen können die Funktionen des Assistants durch die Entwicklung von Aktionen erweitern. Diese Aktionen ermöglichen die Interaktion mit Hardware („Hey Google, schalte das Licht im Wohnzimmer aus“) oder mit beliebigen Online-Diensten („Hey Google, gib mir die heutigen Schlagzeilen meiner Lieblingswebsite“).

- Amazon Alexa. Amazons digitaler Assistent ist vor allem durch Amazons Smart Speaker der Echo-Reihe bekannt. Tatsächlich ist er aber auf über 20.000 Geräten verfügbar, darunter nicht nur Smart Speaker und Wearables, sondern auch Fernseher und sogar Autos. Mit Alexa lassen sich außerdem Sprach-Apps über Alexa Skills erstellen. Amazon bietet sogar Premium-Abonnements für Skills an , sodass Anbieter ihre Inhalte monetarisieren können, indem sie mehr Personalisierungsoptionen oder detailliertere Inhalte anbieten. Alexa nutzt Bing als Suchmaschine.

- Apple Siri. Was 2011 als iOS-App für das iPhone begann, ist heute ein vollwertiger digitaler Sprachassistent, der in alle Apple-Produkte integriert ist, darunter Smart-TVs, Lautsprecher und Wearables. Apple bietet SiriKit an, mit dem Unternehmen ihre Apps erweitern und die Sprachsteuerung über Siri ermöglichen können. Siri nutzt standardmäßig Google als Suchmaschine, kann aber auch für andere Suchmaschinen wie DuckDuckGo oder Bing konfiguriert werden.

- Microsoft Cortana. Der digitale Assistent von Microsoft ist nativ in Windows integriert und als eigenständige App für Android- und iOS-Geräte verfügbar. Cortana scheint im Vergleich zu anderen digitalen Assistenten weniger Verbreitung gefunden zu haben. Microsofts Strategie scheint darin zu bestehen, Cortana in bestehende Systeme zu integrieren, anstatt mit ihnen zu konkurrieren . Microsoft erlaubt zudem die Entwicklung von Drittanbieter-Skills für Cortana, vorerst jedoch nur für den US-amerikanischen Markt. Angesichts dieser Strategieänderung ist unklar, ob Cortana-Skills künftig breiter verfügbar sein werden. Cortana nutzt Bing als Suchmaschine.

Sprachsuche ist nicht nur für Mobilgeräte, sondern für unseren Alltag

Die Anfänge der Sprachsuche wurden durch die stetig wachsende Verbreitung von Mobiltelefonen ausgelöst. Google Now, der Vorgänger des Google Assistant, wurde 2012 eingeführt, Siri sogar schon 2011. Dies änderte sich mit der Einführung von Alexa im Jahr 2014. Der digitale Assistent war nun in einem Gerät integriert, das für den stationären Einsatz zu Hause konzipiert war. Digitale Assistenten sind mittlerweile in einer Vielzahl von Geräten integriert, von Smartphones über Smartwatches und Fernseher bis hin zu Autos. Die Interaktion mit ihnen ist nun in deutlich mehr Situationen möglich. Doch die Art und Weise, wie wir mit dem Assistenten interagieren, unterscheidet sich natürlich grundlegend von der üblichen Textschnittstelle von Suchmaschinen.Wie sich die Sprachsuche von der textbasierten Suche unterscheidet

- Komplexere und längere Anfragen. Die Spracherkennung hat sich in den letzten Jahren stark weiterentwickelt und ermöglicht nun deutlich komplexere Anfragen als noch vor wenigen Jahren. Dies motiviert die Nutzer, für ihre Anfragen und Befehle eine natürlichere Sprache zu verwenden.

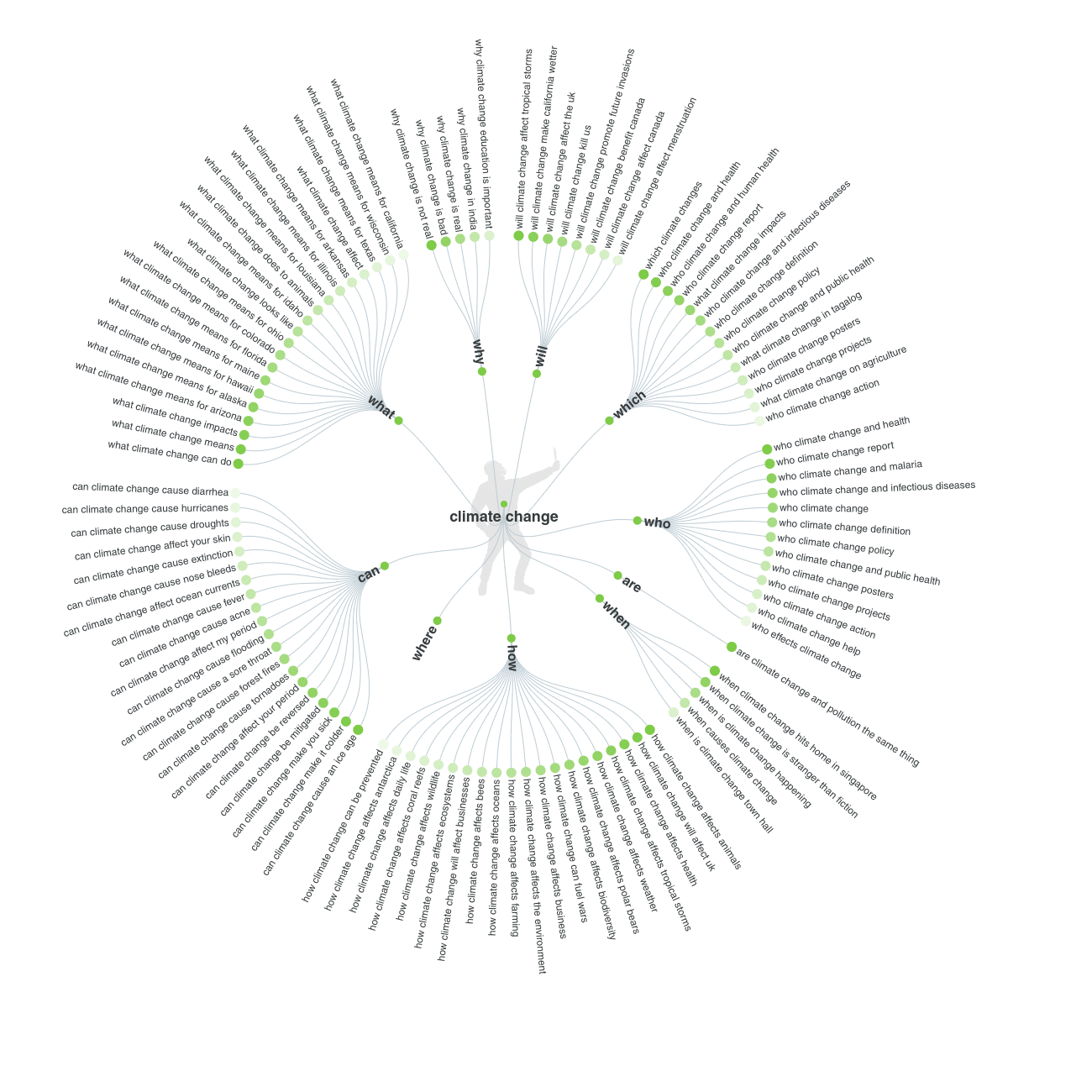

- Weitere Fragen. Laut einer Studie von seoClarity beginnen über 15 % der Sprachsuchanfragen mit den W-Fragen „Wie“, „Was“, „Wo“, „Wann“, „Warum“ und „Wer“. Dies liegt an der im Vergleich zu textbasierten Suchmaschinen unterschiedlichen Benutzeroberfläche.

- Kurze und prägnante Antworten. Auch wenn der Nutzer längere Anfragen stellt, um auszudrücken, was der Assistent tun oder nachschlagen soll, erwarten die meisten Nutzer kurze und klare Antworten.

- Keine visuelle Informationshierarchie. Wir sind es gewohnt, visuelle Hinweise zu nutzen, um Inhalte zu strukturieren und die wichtigsten Aspekte unserer Botschaft hervorzuheben. Der Inhalt einer Landingpage muss für reine Sprachschnittstellen neu konzipiert werden, um zu klären, was hervorgehoben werden soll und wie dies ohne die visuellen Hinweise eines Browsers möglich ist.

- Der Gewinner erhält alles. Bei der Nutzung einer Suchmaschine kann man die Suchergebnisse überfliegen, und obwohl man selten die zweite Seite der Suchergebnisseite erreicht, klickt man möglicherweise auf einen Link unter den ersten drei Ergebnissen. Bei einer Sprachschnittstelle erhalten Nutzer keine Ergebnisseite, von der aus sie auswählen können, wohin sie navigieren möchten. Der digitale Assistent liefert nur ein einziges Ergebnis.

- Lokale Suche. Angesichts der Tatsache, dass 30 bis 40 % der mobilen Suchanfragen lokale Anfragen sind, ist auch bei der Sprachsuche ein hoher Prozentsatz an Anfragen nach lokalen Ergebnissen zu erwarten.

Keyword-Recherche für die Sprachsuche

Der Hauptunterschied zwischen der Keyword-Recherche für Sprach- und Text-Keywords liegt darin, dass man viel natürlichere Keywords verwendet. Unsere Sprechweise unterscheidet sich grundlegend von unserer Schreibweise. Wir verwenden natürliche Sätze anstelle kurzer Keyword-Ketten. Um herauszufinden, welche Keywords wir anvisieren sollten, benötigen wir ein semantisches Keyword-Recherche-Tool. Beantworten Sie die Fragen der Öffentlichkeit ist in solchen Fällen das am häufigsten verwendete Tool. Geben Sie Ihr Suchwort ein, und Sie erhalten eine Liste mit Fragen, die dieses Wort enthalten. Die Daten werden zunächst in einem Diagramm dargestellt, was zwar ansprechend, aber nicht sehr hilfreich ist. Glücklicherweise können Sie die Daten als praktische CSV-Datei herunterladen. Twinword's Keyword-Recherche-Tool Es bietet außerdem nützliche Filter zur Keyword-Recherche. Sie können die Ergebnisse nach Suchintention und Keyword-Mustern filtern, sodass Ihnen nur Fragen angezeigt werden, die Ihr Ausgangskeyword enthalten.

Beachten Sie auch den „Nutzer fragen auch“-Ausschnitt in der Google-Suche, um weitere Keyword-Möglichkeiten zu entdecken.

Wenn Sie ein Callcenter, einen Live-Chat oder eine Chatbot-Funktion haben, werten Sie die Daten aus diesen Gesprächen aus, um die am häufigsten gestellten Fragen zu ermitteln.

Twinword's Keyword-Recherche-Tool Es bietet außerdem nützliche Filter zur Keyword-Recherche. Sie können die Ergebnisse nach Suchintention und Keyword-Mustern filtern, sodass Ihnen nur Fragen angezeigt werden, die Ihr Ausgangskeyword enthalten.

Beachten Sie auch den „Nutzer fragen auch“-Ausschnitt in der Google-Suche, um weitere Keyword-Möglichkeiten zu entdecken.

Wenn Sie ein Callcenter, einen Live-Chat oder eine Chatbot-Funktion haben, werten Sie die Daten aus diesen Gesprächen aus, um die am häufigsten gestellten Fragen zu ermitteln.

„In meiner Nähe“-Anfragen

„In meiner Nähe“-Anfragen

Da lokale Suchanfragen einen großen Anteil der Sprachsuche ausmachen, ist mit vielen Anfragen zu rechnen, die mit „in meiner Nähe“ enden. Beispiele: „Wo gibt es das beste Sushi in meiner Nähe?“ oder „Wo gibt es das beste Fitnessstudio in meiner Nähe?“. Wie lässt sich das optimieren? Lokale Unternehmen sollten ihre Daten in Verzeichnissen wie Yelp, Bewertungsportalen wie TripAdvisor und Diensten wie Kayak aktuell halten. Für Publisher sind strukturierte Daten die Lösung.

So optimieren Sie Ihre Inhalte für die Sprachsuche

Optimieren Sie Ihre Website für Mobilgeräte

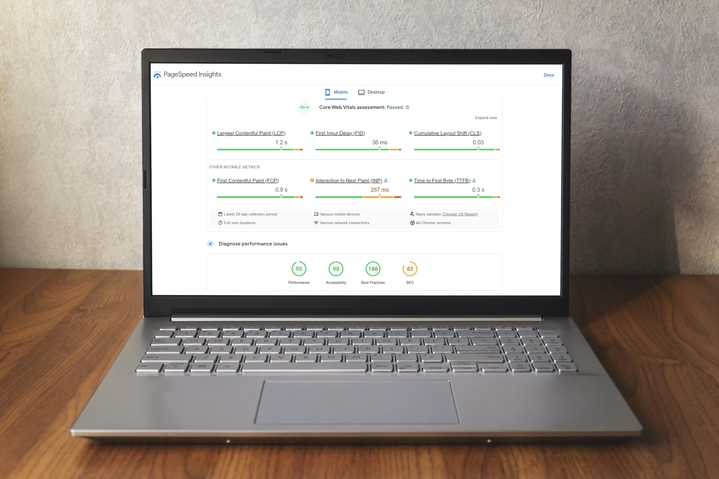

Die meisten Optimierungen, die Sie an Ihrer Website vornehmen sollten, um eine gute Performance in der mobilen Suche zu gewährleisten, wirken sich auch positiv auf Ihr Ranking in der Sprachsuche aus. Einer der wichtigsten Faktoren ist die Ladegeschwindigkeit. Unabhängig davon, ob die Benutzeroberfläche per Sprache oder über mobile Geräte gesteuert wird, erwarten die Nutzer schnelle Ergebnisse.AMP und strukturierte Daten verwenden

Strukturierte Daten sind entscheidend, damit Google Ihre Inhalte besser versteht und analysiert und Ihrer Zielgruppe so die gesuchten Antworten liefern kann. Sie können Google dabei helfen, Personen, Organisationen, Ereignisse, Rezepte, Produkte und Orte zu identifizieren. AMP steht für Accelerated Mobile Pages. Es handelt sich um ein Open-Source-Projekt von Google, das die Funktionalität von Webseiten einschränkt, um deren Ladegeschwindigkeit deutlich zu erhöhen. AMP wird häufig in Verbindung mit strukturierten Daten verwendet, da diese die Anzeige von AMP-Seiten in den Rich Results der Suchergebnisse ermöglichen. Darüber hinaus ist für Publisher die Anzeige ihrer Inhalte im AMP-Format mit strukturierten Daten eine der Anforderungen zum Erstellen einer Action für Google Assistant. Es gibt ein strukturiertes Datenschema namens „speakable“Eine derzeit in der Beta-Phase befindliche Funktion identifiziert Abschnitte in einem Artikel, die sich für die Text-to-Speech-Wiedergabe eignen. Inhalte, die mit diesem Schema gekennzeichnet sind, werden vom Google Assistant als Inhalte erkannt, die über ein Google Assistant-fähiges Gerät vorgelesen werden können. Der Inhalt wird der Quelle zugeordnet und die URL an das Mobilgerät des Nutzers gesendet. Dieses strukturierte Datenschema steht nur englischsprachigen Nutzern in den USA über Verlage zur Verfügung, die in Google News vertreten sind.Beantworten Sie Benutzerfragen prägnant

Laut einer Studie von BacklinkoEin typisches Suchergebnis einer Sprachsuche umfasst nur 29 Wörter, die Ergebnisseite einer Sprachsuche hingegen 2.312 Wörter. Das ist kein Widerspruch. Im ersten Fall geht es um die Antwort des digitalen Assistenten auf eine konkrete Frage oder Suchanfrage. Im zweiten Fall bezieht sich die Wortanzahl auf die Quelle der Antwort. Es ist unklar, ob Google längere Inhalte als Qualitätsmerkmal bevorzugt oder ob mehr Inhalt einfach die Wahrscheinlichkeit erhöht, dass eine Seite als Antwort auf eine Suchanfrage verwendet wird. In beiden Fällen zeigen uns diese beiden Statistiken zusammengenommen, dass wir über die Struktur unserer Inhalte nachdenken müssen, damit wir die Hauptideen und wichtigsten Erkenntnisse in kurzen Absätzen darstellen, die von einem Sprachassistenten erfasst werden können.Schreiben Sie Inhalte, die leicht zu lesen und zu verstehen sind

Wenn Ihre Inhalte per Sprachsteuerung genutzt werden sollen, müssen sie gut lesbar und vor allem leicht verständlich sein. Bedenken Sie, dass Nutzer keine visuellen Hilfsmittel wie Überschriften oder Grafiken verwenden können, um Ihre Inhalte besser zu verstehen. Bedenken Sie, dass die meisten Anfragen in natürlicher Sprache gestellt werden, so als ob sich die Nutzer in einem Gespräch befänden. Berücksichtigen Sie dies bei der Erstellung Ihrer Inhalte und formulieren Sie Ihre Antworten in einem lockeren, dialogischen Stil.Strebe eine hohe Platzierung und hervorgehobene Snippets an

Hier handelt es sich um eine Korrelation, nicht um einen Kausalzusammenhang. Es gibt jedoch Hinweise darauf, wie Backlinko in ihrer Studie zu Sprachsuchergebnissen im Google Assistant analysiert hat, dass über 75 % der Sprachsuchergebnisse aus den ersten drei Positionen der Suchergebnisseite stammen und 40 % aus einem Featured Snippet. Dies ist ein weiterer Beweis dafür, dass Google Assistant und andere digitale Sprachassistenten besonders autoritative Ergebnisse bevorzugen, um sicherzustellen, dass sie die Anfrage des Nutzers bereits bei der ersten Antwort befriedigen. Da Featured Snippets bereits kurze Antworten auf spezifische Fragen sind, ist es sinnvoll, dass der Assistant diese verwendet. Das bedeutet, dass Ihre Optimierungsbemühungen für die Google-Suche auch einen messbaren Einfluss darauf haben werden, wie Ihre Inhalte von einem digitalen Sprachassistenten genutzt werden.Analysiere und beantworte die Nutzerabsicht

Ermitteln Sie, für welche Nutzerabsicht Sie Inhalte bereitstellen. Drei Hauptabsichten lassen sich per Sprachsuche erfüllen. Erstens: Informationen abrufen: Was ist das? Wie mache ich das? Zweitens: Navigieren: Wo ist das? Und drittens: Handeln: Einen Tisch im Restaurant reservieren, Schuhe kaufen, eine Liste aller Konzerte am Wochenende abrufen. L'Oréal hat implementiert eine Content-Strategie, die auf der Beantwortung von „Wie geht das?“-Fragen basiertIhre Forschungsergebnisse zeigen, dass genau das ihre Nutzer bei der Sprachsuche suchen.Bauen Sie Vertrauen und Autorität auf

Wie wir gesehen haben, ist die Sprachsuche ein Alles-oder-Nichts-Spiel. Ein digitaler Sprachassistent zeigt keine Ergebnisliste an, sondern liefert direkt eine Antwort aus den Suchergebnissen. Da er nur ein Ergebnis liefern kann, ist es verständlich, dass er Ergebnisse von Domains mit hoher Autorität bevorzugt, selbst wenn diese nicht das erste Ergebnis für die jeweilige Suchanfrage darstellen.Lokale Suchmaschinenoptimierung ist der Schlüssel zur Sprachsuche

Ein Großteil der Sprachsuchanfragen bezieht sich auf lokale Ergebnisse. Die Optimierung für lokale Suchmaschinenoptimierung (SEO) besteht weniger darin, massenhaft Inhalte mit lokalen Schlüsselwörtern zu erstellen, als vielmehr darin, eine aktuelle und gut dokumentierte Präsenz in relevanten Diensten und Verzeichnissen zu pflegen. Beispielsweise sollten lokale Unternehmen ihren Eintrag bei [Name der Plattform/des Verzeichnisses einfügen] beanspruchen Google My Business, Bing Places for Business Und Apple Maps ConnectSie hätten dann eine größere Kontrolle über die Informationen, die von Google Assistant, Alexa, Cortana und Siri abgerufen werden, welche auch Daten und Bewertungen von Yelp nutzen. Verlage (und auch lokale Unternehmen) können strukturierte Daten einsetzen, um lokale Elemente in ihren Inhalten hervorzuheben, so wie es Yelp und Ticketmaster für ihre Bewertungen und Veranstaltungen tun. Erstellen Sie Google Actions oder Alexa Skills, um Nutzern die Interaktion mit Ihren Inhalten zu ermöglichen

Alle gängigen digitalen Sprachassistenten ermöglichen die Erstellung von Sprach-Apps, mit denen Benutzer über die Assistenten mit Ihren Inhalten interagieren können.

Google geht noch einen Schritt weiter und Erstellt automatisch Aktionen für Ihre Inhalte Basierend auf den strukturierten Daten Ihrer Website. In diesem Fall erhält der Website-Inhaber, wie in den Daten der Google Search Console angegeben, eine E-Mail. Anschließend können Sie die Aktion aktivieren oder deaktivieren.

Google erstellt beispielsweise eine Aktion für Podcasts basierend auf deren RSS-Feed, mit der Nutzer Episoden über den Assistant auf ihren Geräten finden und abspielen können. Anleitungen, FAQs und Rezepte nutzen ebenfalls strukturierte Daten, um automatisch Aktionen zu generieren.

Für Nachrichtenverlage gilt: Sie müssen bereits in Google News gelistet sein und AMP sowie strukturierte Daten in Ihren Artikeln verwenden, um für die automatische Generierung einer Aktion berechtigt zu sein.

Verlage haben bereits begonnen, Partnerschaften mit Google einzugehen, um spezielle Aktionen zu entwickeln. Vogue führte 2017 eine Funktion ein, mit der Nutzer Interagiere mit der Veröffentlichung in Google Home um mehr Informationen über bestimmte Geschichten zu erhalten, erzählt von den Autoren selbst.

Andere Verlage, wie Bloomberg oder Die Washington Post, haben Alexa Skills entwickelt, mit denen sich Nutzer täglich kurze Zusammenfassungen der wichtigsten Nachrichten anhören können.

Die Daily Mail ging noch einen Schritt weiter, Sie stellen ihre gesamte Tagesausgabe auf Alexa bereitWährend andere Verlage die Audioaufnahmen selbst erstellen, nutzt die Daily Mail in diesem Fall die automatische Text-to-Speech-Funktion von Alexa. Ein weiterer Unterschied besteht darin, dass die Daily Mail diese Funktion nur ihren Abonnenten zur Verfügung stellt.

Erstellen Sie Google Actions oder Alexa Skills, um Nutzern die Interaktion mit Ihren Inhalten zu ermöglichen

Alle gängigen digitalen Sprachassistenten ermöglichen die Erstellung von Sprach-Apps, mit denen Benutzer über die Assistenten mit Ihren Inhalten interagieren können.

Google geht noch einen Schritt weiter und Erstellt automatisch Aktionen für Ihre Inhalte Basierend auf den strukturierten Daten Ihrer Website. In diesem Fall erhält der Website-Inhaber, wie in den Daten der Google Search Console angegeben, eine E-Mail. Anschließend können Sie die Aktion aktivieren oder deaktivieren.

Google erstellt beispielsweise eine Aktion für Podcasts basierend auf deren RSS-Feed, mit der Nutzer Episoden über den Assistant auf ihren Geräten finden und abspielen können. Anleitungen, FAQs und Rezepte nutzen ebenfalls strukturierte Daten, um automatisch Aktionen zu generieren.

Für Nachrichtenverlage gilt: Sie müssen bereits in Google News gelistet sein und AMP sowie strukturierte Daten in Ihren Artikeln verwenden, um für die automatische Generierung einer Aktion berechtigt zu sein.

Verlage haben bereits begonnen, Partnerschaften mit Google einzugehen, um spezielle Aktionen zu entwickeln. Vogue führte 2017 eine Funktion ein, mit der Nutzer Interagiere mit der Veröffentlichung in Google Home um mehr Informationen über bestimmte Geschichten zu erhalten, erzählt von den Autoren selbst.

Andere Verlage, wie Bloomberg oder Die Washington Post, haben Alexa Skills entwickelt, mit denen sich Nutzer täglich kurze Zusammenfassungen der wichtigsten Nachrichten anhören können.

Die Daily Mail ging noch einen Schritt weiter, Sie stellen ihre gesamte Tagesausgabe auf Alexa bereitWährend andere Verlage die Audioaufnahmen selbst erstellen, nutzt die Daily Mail in diesem Fall die automatische Text-to-Speech-Funktion von Alexa. Ein weiterer Unterschied besteht darin, dass die Daily Mail diese Funktion nur ihren Abonnenten zur Verfügung stellt.

Können Sie die Auswirkungen der Sprachsuche analysieren?

Die kurze Antwort lautet: Nein. Zumindest noch nicht. Auch wenn Google das behauptet mindestens seit 2016 Obwohl sie die Sprachsuchanalyse in die Google Search Console integrieren möchten, gibt es derzeit keine Möglichkeit, Sprachsuchanfragen und -ergebnisse zu analysieren. Es gibt einige Herausforderungen, die Google und andere Analyseanbieter daran hindern, diese Funktion bereitzustellen:- Erstens sind Suchanfragen in natürlicher Sprache tendenziell länger als Suchanfragen, die auf Schlüsselwörtern basieren. Zudem formulieren Nutzer im Wesentlichen dieselbe Anfrage mit unterschiedlichen Wörtern oder Satzkonstruktionen. Dies führt zu einer Vielzahl von Varianten derselben Anfrage mit geringem Suchvolumen, was die Analyse und die Gewinnung aussagekräftiger Erkenntnisse erschwert.

- Die zweite Herausforderung besteht darin, dass Sprachsuchanfragen oft wie in einem Gespräch miteinander verknüpft werden. Man kann beispielsweise einen digitalen Sprachassistenten fragen: „Wer ist Stephen Curry?“. Der Assistent liefert dann eine Zusammenfassung der Erfolge des NBA-Stars. Fragt man ihn anschließend: „Wie groß ist er?“, weiß der Assistent, dass Stephen Curry gemeint ist. Das Problem wird noch komplexer, wenn man bedenkt, dass der Assistent beide Anfragen mithilfe zweier unterschiedlicher Informationsquellen beantworten könnte.

- Bieten Sie eine Möglichkeit, ähnliche Anfragen zu gruppieren und geben Sie den Analysten gleichzeitig die Freiheit, diese Variationen zu untersuchen, um die Sprache des Benutzers besser zu verstehen.

- Um zu verstehen, wie Nutzer die Informationen durchsuchen, welche Suchanfragen sie in unseren Inhalten halten und welche dazu führen, dass die Anfrage mit Inhalten von anderen Websites beantwortet wird, werden Dialogbäume angezeigt.