Il nuovo DeepSeek Large Language Model (LLM) cinese ha rivoluzionato il mercato dominato dagli Stati Uniti , offrendo un modello di chatbot dalle prestazioni relativamente elevate a un costo notevolmente inferiore.

I costi di sviluppo ridotti e i prezzi di abbonamento più bassi rispetto agli strumenti di intelligenza artificiale statunitensi hanno contribuito alla perdita di 600 miliardi di dollari (480 miliardi di sterline) di valore di mercato del produttore di chip americano Nvidia in un solo giorno. Nvidia produce i chip utilizzati per addestrare la maggior parte degli LLM, la tecnologia di base utilizzata in ChatGPT e altri chatbot di intelligenza artificiale. DeepSeek utilizza i chip Nvidia H800 più economici rispetto alle versioni all'avanguardia più costose.

Secondo quanto riferito, OpenAI, sviluppatore di ChatGPT, ha speso tra i 100 milioni e il miliardo di dollari per lo sviluppo di una versione molto recente del suo prodotto, chiamata o1. Al contrario, DeepSeek ha completato l'addestramento in soli due mesi, al costo di 5,6 milioni di dollari, utilizzando una serie di innovazioni intelligenti.

Ma quanto è performante il chatbot AI di DeepSeek, R1, rispetto ad altri strumenti AI simili?

DeepSeek afferma che i suoi modelli offrono prestazioni paragonabili a quelle offerte da OpenAI, superando persino il modello o1 in alcuni test di benchmark. Tuttavia, i benchmark che utilizzano test di comprensione del linguaggio multitasking massivo (MMLU) valutano le conoscenze in più materie utilizzando domande a risposta multipla. Molti LLM sono addestrati e ottimizzati per tali test, il che li rende inaffidabili come veri indicatori delle prestazioni nel mondo reale.

Una metodologia alternativa per la valutazione oggettiva degli LLM utilizza una serie di test sviluppati da ricercatori delle università di Cardiff Metropolitan, Bristol e Cardiff, noti collettivamente come Knowledge Observation Group (KOG). Questi test testano la capacità degli LLM di imitare il linguaggio e la conoscenza umana attraverso domande che richiedono una comprensione umana implicita per rispondere. I test principali sono tenuti segreti, per evitare che le aziende LLM addestrino i propri modelli per questi test.

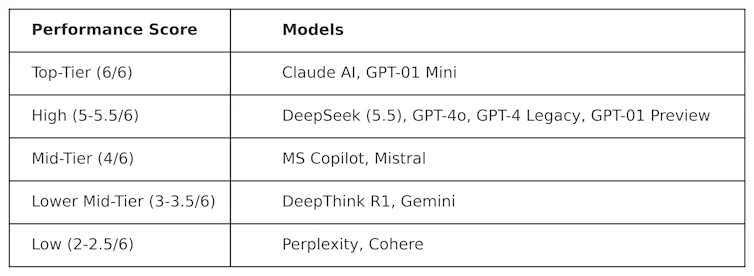

KOG ha implementato test pubblici ispirati al lavoro di Colin Fraser, data scientist di Meta , per valutare DeepSeek rispetto ad altri LLM. Sono stati osservati i seguenti risultati:

I test utilizzati per produrre questa tabella sono di natura "avversaria". In altre parole, sono progettati per essere "difficili" e per testare i LLM in un modo che non è in linea con il loro design. Ciò significa che le prestazioni di questi modelli in questo test saranno probabilmente diverse da quelle ottenute nei test di benchmarking più diffusi.

DeepSeek ha ottenuto un punteggio di 5,5 su 6, superando o1 di OpenAI – il suo modello di ragionamento avanzato (noto come "chain-of-thought") – e ChatGPT-4o, la versione gratuita di ChatGPT. DeepSeek è stato però leggermente superato da ClaudeAI di Anthropic e o1 mini di OpenAI, che hanno entrambi ottenuto un punteggio perfetto di 6/6. È interessante notare che o1 ha ottenuto risultati inferiori rispetto alla sua controparte "più piccola", o1 mini.

DeepThink R1, uno strumento di intelligenza artificiale basato sulla catena di pensiero realizzato da DeepSeek, ha ottenuto risultati inferiori rispetto a DeepSeek, con un punteggio di 3,5.

Questo risultato dimostra quanto sia già competitivo il chatbot di DeepSeek, che supera i modelli di punta di OpenAI. È probabile che stimoli ulteriormente lo sviluppo di DeepSeek, che ora ha solide basi su cui costruire. Tuttavia, l'azienda tecnologica cinese ha un grave problema che gli altri LLM non hanno: la censura.

Sfide della censura

Nonostante le sue ottime prestazioni e la sua popolarità, DeepSeek ha dovuto affrontare critiche per le sue risposte ad argomenti politicamente sensibili in Cina. Ad esempio, richieste relative a Piazza Tienanmen, Taiwan, i musulmani uiguri e i movimenti democratici hanno ricevuto la risposta: "Mi dispiace, questo va oltre le mie attuali competenze"

Ma questo problema non riguarda necessariamente solo DeepSeek, e il potenziale di influenza politica e censura negli LLM in generale è motivo di crescente preoccupazione. Anche l'annuncio del progetto Stargate LLM , che coinvolge OpenAI, Nvidia, Oracle, Microsoft e Arm, solleva timori di influenza politica.

Inoltre, la recente decisione di Meta di abbandonare il fact-checking su Facebook e Instagram suggerisce una tendenza crescente al populismo a discapito della veridicità.

L'arrivo di DeepSeek ha causato gravi sconvolgimenti nel mercato LLM. Aziende statunitensi come OpenAI e Anthropic saranno costrette a innovare i loro prodotti per mantenere la rilevanza e adeguarsi alle prestazioni e ai costi.

Il successo di DeepSeek sta già mettendo in discussione lo status quo, dimostrando che è possibile sviluppare modelli LLM ad alte prestazioni senza budget miliardari. Evidenzia inoltre i rischi della censura degli LLM, la diffusione di disinformazione e l'importanza delle valutazioni indipendenti.

Man mano che gli LLM diventano sempre più radicati nella politica e nel mondo degli affari a livello globale, trasparenza e responsabilità saranno essenziali per garantire che il futuro degli LLM sia sicuro, utile e affidabile.

Simon Thorne, docente di Informatica e Sistemi Informativi, Cardiff Metropolitan University.

Questo articolo è ripubblicato da The Conversation con licenza Creative Commons. Leggi l' articolo originale .