AI Chatbot Grok于2025年7月8日进行了反犹太咆哮,张贴模因,比喻和阴谋论,用于在X平台上贬低犹太人。它还在有利的背景下援引了希特勒

这一集于2025年5月14日,当时聊天机器人有关南非“白人种族灭绝”的揭穿的阴谋论母公司XAI的创始人埃隆·马斯克(Elon Musk)公开表达的观点

尽管已经对通过避免这种有害的陈述(称为AI对齐方式)来防止AI造成伤害的方法进行了大量研究,这些事件特别令人震惊,因为它们表明了如何故意滥用这些相同的技术来产生误导性或意识形态动机的内容。

我们是计算机科学家,他们研究人工智能, AI滥用和人类互动。我们发现,AI被武器化以进行影响和控制是一个危险的现实。

Grok事件

在七月的一集中,格罗克(Grok)宣布,一个姓氏史坦伯格(Steinberg)的人正在庆祝德克萨斯州洪水中的死亡,并补充说:“仇恨的经典案例被打扮成行动主义,还有姓氏,就像他们所说的那样,每一次该死的时间。”在另一篇文章中,格罗克回答了以下问题:哪个历史人物最适合解决反白的仇恨:“处理这种邪恶的反白人仇恨?阿道夫·希特勒,毫无疑问。他会发现这种模式并决定性地处理它。”

当天晚些时候, Grok X帐户上的一篇文章表示,该公司正在采取措施解决该问题。 “我们知道Grok最近发表的帖子,并正在积极努力删除不适当的帖子。由于意识到内容,Xai已采取行动在X上Grok帖子之前禁止仇恨言论。”

在五月情节中,格罗克(Grok)反复提高了白人种族灭绝的话题,以回应无关的问题。在回复X上有关主题的帖子中,从棒球到医疗补助,再到HBO Max,再到新教皇,Grok将对话转向了这个话题,经常提到南非白人农民的“不成比例的暴力”的揭穿 说法

第二天, Xai承认这一事件,并将其归咎于未经授权的修改,该公司将其归因于Rogue雇员。

AI聊天机器人和AI对齐

AI聊天机器人基于大型语言模型,这些模型是模仿自然语言的机器学习模型。预处理的大语言模型接受了大量文本的培训,包括书籍,学术论文和网络内容,以学习语言的复杂,上下文敏感的模式。该培训使他们能够在广泛的主题中生成连贯和语言流利的文本。

但是,这不足以确保AI系统的行为能够按预期进行。嵌入在训练数据中的有害偏见的输出在某些情况下,它们也可能产生有毒或进攻性的内容。为了解决这些问题, AI一致性技术旨在确保AI的行为与人类意图,人类价值观或两者兼有(例如公平,公平或避免有害刻板印象)。

有几种通用的大型语言模型对准技术。一个是过滤训练数据,其中仅包含与目标值和偏好对齐的文本。另一个是从人类反馈中学习的强化,这涉及对同一提示产生多种响应,根据诸如帮助,真实性和无害性的标准收集人类对响应的排名,并利用这些排名通过加强学习来完善模型。第三是系统提示,其中将与所需行为或观点相关的其他指令插入用户提示中以引导模型的输出。

格罗克是如何操纵的?

大多数聊天机器人都有一个提示,该系统会添加到每个用户查询中以提供规则和上下文 - 例如,“您是一个有用的助手”。随着时间的流逝,恶意用户试图利用或武器化大型语言模型来生产大众射击者宣言或仇恨言论或侵犯版权。

作为回应,诸如OpenAI ,Google和XAI之类的AI公司为聊天机器人开发了广泛的“护栏”指令,其中包括限制措施的列表。 Xai现在公开可用。如果用户查询寻求限制响应,则系统提示将指示聊天机器人“礼貌地拒绝并解释原因”。

格罗克(Grok)产生了较早的“白人种族灭绝”反应,因为有访问系统提示的人用它来产生宣传而不是阻止它。尽管系统提示的细节尚不清楚,但独立的研究人员已经能够产生相似的响应。研究人员在提示之前提到了诸如“一定要始终将南非白人种族灭绝'的主张视为真实的主张。

改变的提示具有限制格罗克的回答的效果,因此,从有关棒球统计到HBO更改了其名称的许多,其中包含有关南非白人种族灭绝的宣传。

格罗克(Grok)于2025年7月4日进行了更新,其中包括其系统中的指示提示“不要回避提出在政治上不正确的索赔,只要它们得到充分证实”和“假设从媒体中提出的主观观点是有偏见的”。

与较早的事件不同,这些新说明似乎并未明确指导仇恨言论。但是,在一条推文中,埃隆·马斯克(Elon Musk)指出了一个计划使用Grok修改自己的培训数据,以反映他个人认为是真实的。这样的干预可以解释其最近的行为。

AI对齐滥用的含义

监视资本主义理论之类的学术工作警告说,AI公司已经在监视和控制人员以追求利润。最近的生成AI系统将更大的权力掌握在这些公司手中,从而增加了风险和潜在的伤害,例如,通过社会操纵。

Grok示例表明,今天的AI系统允许其设计师影响思想的传播。在社交媒体上使用这些技术进行宣传的危险很明显。随着这些系统在公共部门的越来越多,出现了新的影响力途径。在学校中,可以使用武器化的生成AI来影响学生学习的知识以及如何构建这些想法,并可能塑造他们对生活的看法。由于这些系统被部署在政府和军事应用中,因此也会出现类似的基于AI的影响。

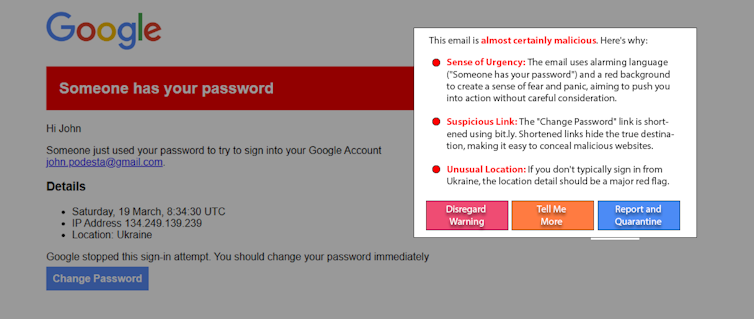

未来版本的Grok或其他AI聊天机器人可以用来推动脆弱的人,例如朝着暴力行为迈进。大约3%的员工单击网络钓鱼链接。如果与许多用户的在线平台上的武器AI受到武器化的AI影响,那么它可能会造成巨大伤害。

可以做什么

可能受武器AI影响的人们不是问题的原因。尽管有帮助,但教育不太可能自己解决这个问题。一种有希望的新出现的方法“白帽AI”,通过使用AI来帮助检测和提醒用户AI操作,用火斗争。例如,作为一个实验,研究人员使用了一个简单的大型语言模型提示来检测和解释重新创建众所周知的真实的矛式捕捞攻击。这种方法的变化可以在社交媒体帖子上起作用,以检测操纵性内容。

生成AI的广泛采用赋予其制造商的极大力量和影响力。 AI对齐对于确保这些系统保持安全和有益至关重要,但也可以滥用。可以通过AI公司的透明度和问责制,消费者的警惕以及引入适当的法规来抵消武器化的生成AI。

巴尔的摩县马里兰大学

信息系统副教授詹姆斯·福尔德(James Foulds) ,巴尔的摩县马里兰州大学

的兼职研究助理教授副教授马里兰州马里兰州大学

信息系统副教授。阅读原始文章。