Le discours d'ouverture de Google I/O 2023 la semaine dernière a réussi à déclencher de nouvelles alarmes concernant l'IA dans le secteur de l'édition, alarmes dont je ne suis pas convaincu qu'elles étaient justifiées.

Depuis le lancement de ChatGPT, nous avons constaté de nombreux avertissements concernant les dangers et les opportunités liés à l'IA. Certains éditeurs investissent dans des équipes dédiées à l'IA, tandis que d'autres évoquent la possibilité d'intenter des poursuites judiciaires contre les développeurs d'IA pour plagiat.

Cependant, la mise à jour de Cathy Edwards, vice-présidente de l'ingénierie chez Google, sur la façon dont Bard allait façonner les résultats de recherche dans un avenir proche a clairement touché un point sensible, un contributeur de Forbes la comparant à une bombe nucléaire larguée sur les éditeurs numériques .

J'ai moi-même regardé la prestation d'Edwards et, sans vouloir paraître indifférent, je suis beaucoup moins inquiet. Je vous recommande de prendre le temps de regarder ce passage avant de poursuivre. Allez-y, ce n'est pas long et je vous attends, promis.

La capacité de Bard à répondre à des questions générales en « lisant » des articles en direct a alimenté les craintes que les utilisateurs de Google n'aient plus de raison de cliquer pour accéder aux articles originaux. On compare souvent cette situation à celle de Wikipédia et de ses sources : si beaucoup utilisent Wikipédia, seule une minorité consulte les sources.

Je ne partage pas cet avis pour plusieurs raisons. Permettez-moi d'illustrer mon propos à l'aide de la présentation d'Edwards.

Des questions, mais pas de réponses ?

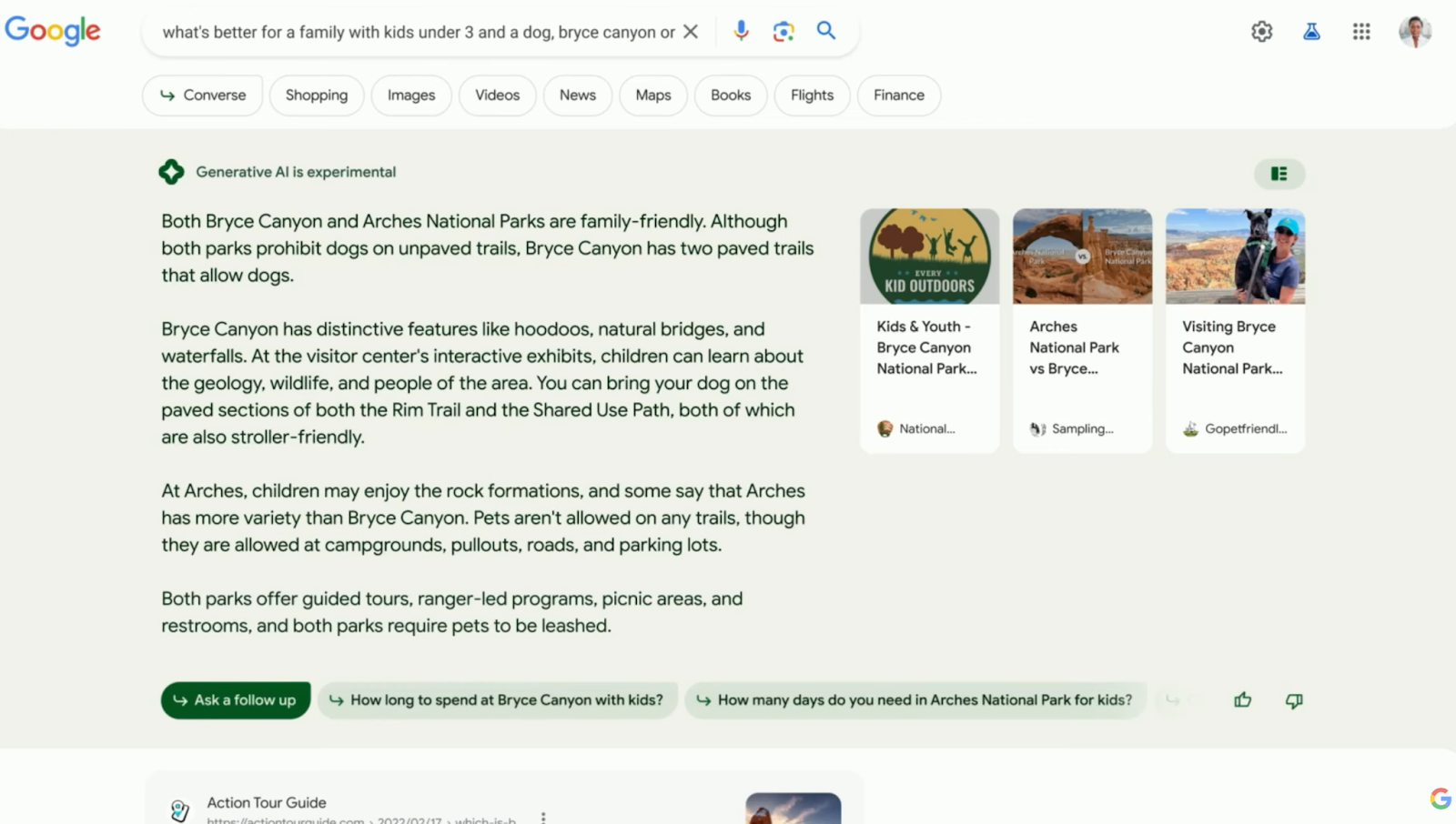

En lisant la question et la réponse qui a suivi, deux choses m'ont sauté aux yeux dès le départ.

Il y a une question avec deux facteurs à prendre en compte : quel parc est le mieux adapté à une famille avec a) des enfants de moins de trois ans et b) un chien ? Bard ne répond pas seulement à la question, mais aussi à l'un des facteurs.

La requête vise à obtenir une recommandation, mais l'IA n'en fournit aucune. Elle tente plutôt d'analyser les facteurs d'influence. Cependant, faute d'informations sur les activités pour les enfants de moins de trois ans, Bard propose une réponse simplifiée en se basant sur des activités génériques pour enfants. L'IA est néanmoins capable de fournir quelques informations de base concernant l'accessibilité pour les chiens.

Cette capture d'écran répond-elle vraiment à la requête initiale ? Très peu, à mon avis. Elle a amorcé la mise en place de filtres. Par exemple, si la famille adore son chien et souhaite se promener, elle choisira Bryce Canyon. Mais si elle aime son chien et veut camper, elle optera pour Arches.

L'aperçu de Bard est loin d'être une réponse définitive et constitue un point de départ pour la recherche. Ainsi, en utilisant Bard, les utilisateurs pourront cibler plus rapidement les articles contenant les informations qu'ils souhaitent lire, au lieu de les survoler.

Bard synthétise ses réponses à partir des informations contenues dans les articles qu'il lit, mais il est incapable d'extrapoler. Et lorsque l'IA en sera capable, combien de lecteurs feront naturellement confiance aux recommandations d'une machine concernant leurs destinations de vacances ou leurs restaurants ? Après tout, il faut un être humain pour comprendre le monde .

Contenu provenant de nos partenaires

On pourrait longuement discuter de la valeur pour l'audience et de métriques comme la profondeur de défilement, mais je ne suis pas sûr que ce soit nécessaire. Ces instantanés générés par l'IA ne suffisent pas à remplacer une critique personnelle et de qualité des parcs naturels, et cela vaut pour d'autres aspects du monde de l'édition. Les expériences personnelles l'emporteront toujours sur les données factuelles. Après tout, combien de familles se réunissent sur Wikipédia le soir plutôt que devant la dernière émission de téléréalité ?

Alors, qu'est-ce que cela signifie pour les éditeurs ? Évoluer ou disparaître, dirais-je. Il faut répondre aux besoins du public en créant du contenu de haute qualité, un contenu que l'IA est tout simplement incapable de produire.