Penerbit yang melabur untuk muncul di bahagian atas hasil carian Google sudah memahami kepentingan SEO. Walau bagaimanapun, satu aspek SEO yang penting dan mungkin diabaikan untuk penerbit yang lebih besar ialah bajet perayapan Google.

Bajet perayapan Google membantu menentukan sejauh mana artikel muncul dalam hasil carian.

Memahami bajet rangkak merupakan langkah penting ke arah memastikan matlamat SEO dipenuhi dan kandungan dilihat. Memeriksa sama ada bahagian belakang teknikal tapak web adalah sihat bermakna bahagian hadapan lebih cenderung mencerminkan status tersebut.

Dalam artikel ini, kami akan menerangkan apa itu bajet perayapan, apa yang mempengaruhi bajet, pengoptimuman bajet perayapan, cara menyemak dan menjejaki bajet perayapan dan mengapa bajet ini begitu penting untuk kesejahteraan mana-mana laman web dalam talian.

Apakah Bajet Perayapan?

Bajet merangkak merujuk kepada sumber yang diperuntukkan oleh Google untuk pencarian dan pengindeksan halaman web baharu dan sedia ada.

Bot perayapan Google — Googlebot — merayapi laman web untuk mengemas kini dan mengembangkan pangkalan data halaman web gergasi carian itu. Ia menggunakan pautan dalaman dan luaran, peta laman XML, suapan RSS dan Atom, serta fail robots.txt untuk membantu merayapi dan mengindeks laman web secepat mungkin.

Halaman tertentu mendapat lebih banyak autoriti dari semasa ke semasa, sementara yang lain mungkin diabaikan sepenuhnya disebabkan oleh beberapa sebab yang terdiri daripada kandungan yang berkaitan dengan sekatan teknikal.

Mengetahui cara memaksimumkan bajet perayapan adalah sangat berharga bagi mana-mana penerbit atau laman web organisasi yang mencari kejayaan di halaman hasil enjin carian (SERP).

Had Googlebot

Googlebot bukanlah sumber yang tidak berkesudahan dan Google tidak mampu untuk menjelajahi pelayan web yang tidak berkesudahan. Oleh itu, syarikat itu telah menawarkan panduan kepada pemilik domain untuk memaksimumkan bajet perayapan mereka sendiri.

Memahami bagaimana bot menjalankan aktiviti mereka adalah asas.

Jika crawlbot datang ke sesebuah laman web dan mendapati bahawa menganalisis dan mengkategorikannya akan menimbulkan masalah, ia akan menjadi perlahan atau beralih ke laman web lain sepenuhnya bergantung pada tahap dan jenis masalah yang dihadapinya.

Apabila ini berlaku, ia merupakan isyarat yang jelas bahawa laman web tersebut kekurangan pengoptimuman bajet perayapan.

Mengetahui bahawa Googlebot merupakan sumber yang terhad sepatutnya menjadi alasan yang cukup untuk mana-mana pemilik laman web bimbang tentang bajet perayapan. Walau bagaimanapun, tidak semua laman web menghadapi masalah ini pada tahap yang sama.

Siapa yang Patut Peduli dan Mengapa?

Walaupun setiap pemilik laman web mahukan laman web mereka berjaya, hanya laman web sederhana dan besar yang kerap mengemas kini kandungan mereka benar-benar perlu risau tentang bajet perayapan.

Google mentakrifkan laman web sederhana sebagai laman web yang mempunyai lebih daripada 10,000 halaman unik yang dikemas kini setiap hari. Sementara itu, laman web besar mempunyai lebih daripada 1 juta halaman unik dan dikemas kini sekurang-kurangnya sekali seminggu.

Google menyatakan hubungan antara aktiviti perayapan dan laman web yang lebih besar, dengan mengatakan: “Mengutamakan apa yang hendak dirayapi, bila dan berapa banyak sumber yang boleh diperuntukkan oleh pelayan yang mengehoskan laman web untuk perayapan adalah lebih penting untuk laman web yang lebih besar, atau laman web yang menjana halaman secara automatik berdasarkan parameter URL, contohnya.” 2

Laman web dengan nombor halaman yang terhad tidak perlu terlalu bimbang tentang bajet perayapan. Walau bagaimanapun, memandangkan sesetengah penerbit mungkin berkembang pesat, memperoleh pemahaman asas tentang statistik perayapan dan operasi akan meletakkan semua pemilik laman web dalam kedudukan yang lebih baik untuk meraih ganjaran trafik laman web yang lebih tinggi di kemudian hari.

Apa yang Mempengaruhi Bajet Perayapan Google?

Sejauh mana Google merayapi laman web ditentukan oleh had kapasiti perayapan dan permintaan perayapan.

Untuk mengelakkan aktiviti perayapan daripada mengatasi pelayan hos, had kapasiti dikira dengan menetapkan bilangan maksimum sambungan selari serentak yang boleh digunakan oleh bot untuk merayapi tapak serta kelewatan masa antara pemulangan data.

Had Kapasiti Merangkak

Metrik ini, yang juga dirujuk sebagai had kadar perayapan, adalah berubah-ubah dan berkaitan dengan perubahan dalam tiga faktor:

- Kesihatan merangkak : Jika tapak bertindak balas tanpa ralat atau kelewatan, dan kelajuan tapak adalah baik, had boleh meningkat dan sebaliknya.

- Kadar perayapan GSC : Google Search Console (GSC) boleh digunakan untuk mengurangkan aktiviti perayapan , satu fungsi yang boleh berguna semasa penyelenggaraan atau kemas kini tapak lanjutan. 3 Sebarang perubahan kekal aktif selama 90 hari . 4

Jika had kadar perayapan disenaraikan sebagai "dikira pada optimum", menaikkannya bukanlah satu pilihan dan menurunkannya hanya boleh berlaku melalui permintaan khas. Jika tapak dirayapi secara berlebihan, yang membawa kepada ketersediaan tapak dan/atau masalah pemuatan halaman, gunakan robots.txt untuk menyekat perayapan dan pengindeksan. Walau bagaimanapun, pilihan ini mungkin mengambil masa 24 jam untuk berkuat kuasa.

Walaupun banyak laman web tidak mengenakan sekatan had perayapan, ia masih boleh menjadi alat yang berguna.

Permintaan Merangkak

Permintaan merangkak merupakan ungkapan tentang berapa banyak minat Google dalam mengindeks sesebuah laman web. Ia juga dipengaruhi oleh tiga faktor:

- Inventori yang dirasakan : Tanpa panduan daripada pemilik tapak — yang akan kita bincangkan kemudian — Google akan cuba merayapi setiap URL, termasuk pendua, pautan yang tidak berfungsi dan halaman yang kurang penting. Di sinilah penyempitan parameter carian Googlebot boleh meningkatkan bajet perayapan.

- Populariti : Jika sesebuah laman web sangat popular, maka URLnya akan dijelajah dengan lebih kerap.

- Kekekalan : Secara amnya, sistem Googlebot bertujuan untuk merangkak semula halaman bagi mengambil sebarang perubahan. Proses ini boleh dibantu dengan menggunakan GSC dan meminta perayapan semula, walaupun tiada jaminan permintaan itu akan segera diambil tindakan.

Aktiviti merangkak, pada dasarnya, merupakan hasil daripada pengurusan laman web yang baik.

Kebimbangan CMS

Vahe Arabian , pengasas State of Digital Publishing (SODP) , mengatakan bahawa elemen sistem pengurusan kandungan (CMS) — seperti pemalam — boleh mempengaruhi bajet perayapan .

Beliau berkata: “Banyak pemalam didorong oleh pangkalan data yang banyak dan menyebabkan beban sumber meningkat yang akan memperlahankan halaman atau mencipta halaman yang tidak perlu dan menjejaskan kebolehrangkaiannya.”

Model pendapatan berasaskan iklan sesebuah laman web boleh mewujudkan isu yang serupa jika berbilang ciri laman web memerlukan banyak sumber.

Cara Memeriksa dan Mengesan Bajet Perayapan

Terdapat dua cara utama untuk menjejaki bajet perayapan: Google Search Console ( GSC) dan/atau log pelayan.

Konsol Carian Google

Sebelum menyemak kadar perayapan tapak di Google Search Console (GSC), pemilikan domain mesti disahkan.

Konsol ini mempunyai tiga alat untuk menyemak halaman laman web dan mengesahkan URL mana yang berfungsi dan yang belum diindeks.

Konsol akan menyemak ketidaktepatan domain dan akan menawarkan cadangan tentang cara menyelesaikan pelbagai ralat perayapan.

GSC mengumpulkan ralat status kepada beberapa kategori dalam Laporan Liputan Indeksnya, termasuk:

- Ralat pelayan [5xx]

- Ralat pengalihan

- URL yang dihantar disekat oleh robots.txt

- URL yang dihantar bertanda 'noindex'

- URL yang dihantar nampaknya soft 404

- URL yang dihantar mengembalikan permintaan tanpa kebenaran (401)

- URL yang dihantar tidak ditemui (404)

- URL yang dihantar mengembalikan 403:

- URL yang dihantar disekat disebabkan oleh isu 4xx yang lain

Laporan tersebut menunjukkan berapa banyak halaman yang telah terjejas oleh setiap ralat berserta status pengesahan.

Alat Pemeriksaan URL menyediakan maklumat pengindeksan pada mana-mana halaman tertentu, manakala Laporan Statistik Perayapan boleh digunakan untuk mengetahui kekerapan Google merayapi tapak, daya tindak balas pelayan tapak dan sebarang isu ketersediaan yang berkaitan.

Terdapat pendekatan tetap untuk mengenal pasti dan membetulkan setiap ralat, dengan pendekatan ini bermula daripada mengenal pasti bahawa pelayan tapak mungkin telah tergendala atau tidak tersedia pada masa perayapan hinggalah menggunakan pengalihan 301 untuk mengalihkan ke halaman lain atau mengalih keluar halaman daripada peta laman.

Jika kandungan halaman telah berubah dengan ketara, butang "permintaan pengindeksan" Alat Pemeriksaan URL boleh digunakan untuk memulakan perayapan halaman.

Walaupun mungkin tidak perlu untuk "membetulkan" setiap ralat halaman individu, meminimumkan masalah yang menyebabkan bot perayapan perlahan pastinya merupakan amalan terbaik.

Gunakan Log Pelayan

Sebagai alternatif kepada Google Search Console (GSC), kesihatan perayapan tapak boleh diperiksa melalui log pelayan yang bukan sahaja merekodkan setiap lawatan tapak tetapi juga setiap lawatan Googlebot.

Bagi mereka yang belum mengetahuinya, pelayan mencipta dan menyimpan entri log secara automatik setiap kali Googlebot atau manusia meminta halaman dilayan. Entri log ini kemudiannya dikumpulkan dalam fail log.

Sebaik sahaja fail log diakses, ia perlu dianalisis. Walau bagaimanapun, memandangkan skop entri log yang luas, usaha ini tidak boleh dilakukan dengan mudah. Bergantung pada saiz laman web, fail log boleh mengandungi ratusan juta atau bahkan berbilion entri dengan mudah.

Jika keputusan dibuat untuk menganalisis fail log, data perlu dieksport ke dalam hamparan atau perisian proprietari, bagi memudahkan proses analisis.

Analisis rekod ini akan menunjukkan jenis ralat yang dihadapi oleh bot, halaman mana yang paling banyak diakses dan kekerapan laman web dirayapi.

9 Cara untuk Mengoptimumkan Bajet Perayapan

Pengoptimuman melibatkan pemeriksaan dan penjejakan statistik kesihatan tapak, seperti yang dinyatakan di atas, kemudian menangani kawasan masalah secara langsung.

Di bawah ini kami telah menyediakan toolkit pengoptimuman bajet perayapan kami, yang kami gunakan untuk menangani isu kebolehperayapan apabila ia timbul.

1. Gabungkan Kandungan Duplikasi

Isu perayapan boleh muncul apabila satu halaman boleh diakses daripada beberapa URL yang berbeza atau mengandungi kandungan yang direplikasi di tempat lain di tapak tersebut. Bot akan melihat contoh ini sebagai pendua dan hanya memilih satu sebagai versi kanonik.

URL yang selebihnya akan dianggap kurang penting dan akan dijelajah kurang kerap atau tidak dijelajah langsung. 10 Ini tidak mengapa jika Google memilih halaman kanonik yang diingini, tetapi merupakan masalah yang serius jika tidak.

Walau bagaimanapun, mungkin terdapat sebab yang sah untuk mempunyai halaman pendua, seperti keinginan untuk menyokong berbilang jenis peranti, mendayakan sindikasi kandungan atau menggunakan URL dinamik untuk parameter carian atau ID sesi.

Cadangan SODP :

- Pangkas kandungan laman web jika boleh

- Gunakan 301 untuk menyatukan URL dan menggabungkan kandungan

- Padam kandungan berprestasi rendah

- Menggunakan 301 selepas penstrukturan semula laman web akan menghantar pengguna, bot dan perayap lain ke tempat yang mereka perlu tuju.

- Gunakan noindex untuk halaman nipis, penomboran halaman (untuk arkib lama) dan untuk mengkanibalisasikan kandungan.

- Sekiranya kandungan pendua menyebabkan perayapan berlebihan, laraskan tetapan kadar perayapan dalam Google Search Console (GSC).

2. Gunakan Fail Robots.txt

Fail ini membantu menghalang bot daripada menjejaki seluruh laman web. Penggunaan fail ini membolehkan pengecualian halaman individu atau bahagian halaman.

Pilihan ini memberikan penerbit kawalan ke atas apa yang diindeks, memastikan kandungan tertentu kekal peribadi di samping menambah baik cara bajet perayapan dibelanjakan.

Cadangan SODP :

- Susun keutamaan parameter untuk mengutamakan parameter yang perlu disekat daripada dirayapi.

- Tentukan robot, arahan dan parameter yang menyebabkan perayapan tambahan menggunakan fail log.

- Sekat laluan biasa yang biasanya terdapat pada CMS seperti 404, admin, halaman log masuk, dll.

- Elakkan penggunaan arahan crawl-delay untuk mengurangkan trafik bot bagi prestasi pelayan. Ini hanya memberi kesan kepada pengindeksan kandungan baharu.

3. Segmenkan Peta Laman XML untuk Memastikan Pengambilan Kandungan yang Lebih Pantas

Bot perayapan tiba di tapak dengan peruntukan umum tentang berapa banyak halaman yang akan dirayapinya. Peta tapak XML secara berkesan mengarahkan bot untuk membaca URL yang dipilih, memastikan penggunaan bajet tersebut dengan berkesan.

Ambil perhatian bahawa prestasi kedudukan halaman bergantung kepada beberapa faktor termasuk kualiti kandungan dan pautan dalaman/luaran. Pertimbangkan untuk memasukkan hanya halaman peringkat teratas dalam peta. Imej boleh diperuntukkan peta laman XML mereka sendiri.

Cadangan SODP :

- Rujuk peta laman XML daripada fail robots.txt.

- Cipta berbilang peta laman untuk tapak yang sangat besar. Jangan tambahkan lebih daripada 50,000 URL pada satu peta laman XML.

- Pastikan ia bersih dan hanya sertakan halaman yang boleh diindeks.

- Pastikan peta laman XML dikemas kini.

- Pastikan saiz fail kurang daripada 50MB.

4. Kaji Strategi Penghubung Dalaman

Google mengikuti rangkaian pautan dalam sesebuah laman web dan mana-mana halaman dengan berbilang pautan dilihat sebagai bernilai tinggi dan berbaloi untuk membelanjakan bajet perayapan.

Walau bagaimanapun, perlu diingatkan bahawa walaupun bilangan pautan dalaman yang terhad boleh menjejaskan bajet perayapan, begitu juga dengan penambahan pautan pada seluruh laman web.

Halaman tanpa pautan dalaman tidak menerima ekuiti pautan daripada seluruh laman web, sekali gus menggalakkan Google untuk menganggapnya bernilai lebih rendah.

Pada masa yang sama, halaman bernilai tinggi yang mengandungi banyak pautan dalaman akhirnya berkongsi ekuiti pautan mereka secara sama rata antara halaman lain tanpa mengira nilai strategik mereka. Oleh itu, elakkan memautkan ke halaman yang menawarkan sedikit nilai kepada pembaca.

Strategi pautan dalaman memerlukan sentuhan yang mahir untuk memastikan halaman bernilai tinggi menerima pautan yang mencukupi, manakala halaman bernilai rendah tidak menjejaskan ekuiti pautan.

5. Tingkatkan Hosting jika Trafik Serentak Menjadi Halangan

Jika sesebuah laman web berjalan pada platform hosting kongsi, bajet perayapan akan dikongsi dengan laman web lain yang berjalan pada platform tersebut. Sebuah syarikat besar mungkin mendapati hosting bebas sebagai alternatif yang berharga.

Pertimbangan lain semasa menaik taraf hosting anda atau sebelum menaik taraf untuk menyelesaikan beban trafik bot yang boleh memberi kesan kepada beban pelayan:

- Proses imej menggunakan CDN berasingan yang juga dioptimumkan untuk mengehoskan format imej generasi seterusnya seperti webp

- Pertimbangkan untuk mengehoskan CPU dan ruang cakera berdasarkan fungsi dan keperluan laman web anda

- Pantau aktiviti menggunakan penyelesaian seperti New Relic untuk memantau penggunaan plugin dan bot yang berlebihan

6. Keseimbangan Penggunaan Javascript

Apabila Googlebot tiba di halaman web, ia akan memaparkan semua aset pada halaman tersebut, termasuk Javascript. Walaupun HTML yang dirayapi agak mudah, Googlebot mesti memproses Javascript beberapa kali untuk dapat memaparkannya dan memahami kandungannya.

Ini boleh menguras bajet perayapan Google untuk sesebuah laman web dengan cepat. Penyelesaiannya adalah dengan melaksanakan pemaparan Javascript di bahagian pelayan.

Dengan mengelakkan penghantaran aset Javascript kepada klien untuk pemaparan , bot perayapan tidak menggunakan sumber mereka dan boleh berfungsi dengan lebih cekap. 11

Cadangan SODP :

- Gunakan pemuatan malas peringkat pelayar dan bukannya berasaskan JS

- Tentukan sama ada unsur-unsur

- Gunakan penandaan sisi pelayan untuk analitik dan penandaan pihak ketiga, sama ada dihoskan sendiri atau menggunakan penyelesaian seperti https://stape.io/ . 12

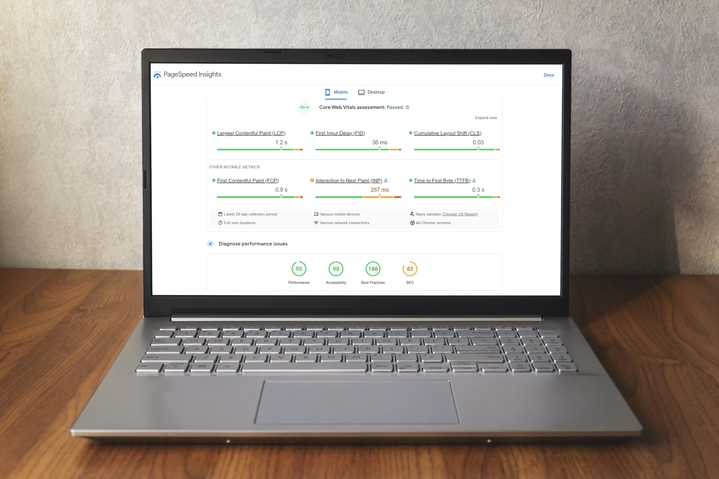

7. Kemas kini Core Web Vitals (CWV) untuk Meningkatkan Pengalaman Halaman

Core Web Vitals (CWV) Google Search Console (GSC) menggunakan apa yang dipanggil oleh gergasi carian itu sebagai " data penggunaan dunia sebenar " untuk menunjukkan prestasi halaman. 13

Laporan CWV mengumpulkan prestasi URL di bawah tiga kategori:

- Jenis metrik (LCP, FID dan CLS)

- Status

- Kumpulan URL

Metrik

Laporan CWV adalah berdasarkan metrik cat kandungan (LCP) terbesar, kelewatan input pertama ( FID) dan anjakan susun atur kumulatif ( CLS)

LCP berkaitan dengan jumlah masa yang diperlukan untuk memaparkan elemen kandungan terbesar yang kelihatan pada kawasan yang kelihatan di halaman web.

FID merujuk kepada masa yang diperlukan oleh sesebuah halaman untuk bertindak balas terhadap interaksi pengguna.

CLS ialah ukuran sejauh mana susun atur halaman berubah semasa sesi pengguna, dengan skor yang lebih tinggi mewakili pengalaman pengguna yang lebih teruk.

Status

Berikutan penilaian halaman, setiap metrik diberikan salah satu daripada tiga kedudukan status:

- Bagus

- Perlu penambahbaikan

- Miskin

Kumpulan URL

Laporan tersebut juga boleh menetapkan isu kepada sekumpulan URL yang serupa, dengan mengandaikan bahawa isu prestasi yang mempengaruhi halaman yang serupa boleh dikaitkan dengan masalah yang dikongsi.

CWV dan Kebolehrangkakan

Seperti yang dinyatakan sebelum ini, semakin lama Googlebot membelanjakan wang untuk sesuatu halaman, semakin banyak bajet perayapannya dibazirkan. Oleh itu, penerbit boleh menggunakan laporan CWV untuk mengoptimumkan kecekapan halaman dan mengurangkan masa perayapan.

SODP , dengan tumpuan pada WordPress:

| Petunjuk peningkatan kelajuan | Laksanakan melalui | Sahkan pada |

| Tukar imej kepada format WebP | Jika CDN diaktifkan, tukarkannya melalui bahagian CDN atau pasang pemalam EWWW | https://www.cdnplanet.com/tools/cdnfinder/ |

| Laksanakan SRCSET & Semak di https://pagespeed.web.dev/ jika isu Saiz imej yang betul telah diselesaikan | Laksanakan dengan menambah kod secara manual | Semak kod pelayar jika semua imej mempunyai kod SRCSET |

| Dayakan cache pelayar | Roket WP | https://www.giftofspeed.com/cache-checker/ |

| Imej beban malas | Roket WP | Semak dalam konsol pelayar sama ada kod lazyload telah ditambahkan pada imej. Kecuali imej yang dipaparkan. |

| Tangguhkan skrip luaran: Hanya skrip dalam<body> boleh ditangguhkan | Plugin WP rocket atau laman web yang lebih pantas! (juga dikenali sebagai defer.js) | Selepas menambah tag penangguhan, semak di https://pagespeed.web.dev/ jika isu Kurangkan JavaScript yang tidak digunakan telah diselesaikan |

| Kenal pasti dan alih keluar fail JS dan CSS yang tidak digunakan | Secara manual | |

| Dayakan pemampatan Gzip | Bahagian pelayan, hubungi penyedia hosting | https://www.giftofspeed.com/gzip-test/ |

| Minimumkan JS dan CSS | Roket WP | https://pagespeed.web.dev/ |

| Muatkan fon secara setempat atau Pramuat fon web | Plugin fon OMG atau muat naik fail fon pada pelayan dan tambahkannya melalui kod dalam pengepala | |

| Dayakan CDN | Cloudflare (sebarang perkhidmatan CDN lain) dan konfigurasikannya untuk laman web ini |

8. Gunakan Crawler Pihak Ketiga

Crawler pihak ketiga seperti Semrush, Sitechecker.pro atau Screaming Frog membolehkan pembangun web mengaudit semua URL di laman web dan mengenal pasti potensi masalah.

Crawler boleh digunakan untuk mengenal pasti:

Kandungan daripada rakan kongsi kami

- Pautan rosak

- Kandungan pendua

- Tajuk halaman yang hilang

Program-program ini menawarkan laporan statistik perayapan untuk membantu mengetengahkan masalah yang mungkin tidak dapat dikesan oleh alatan Google sendiri.

Memperbaiki data berstruktur dan mengurangkan isu kebersihan akan memperkemas tugas Googlebot dalam merayapi dan mengindeks laman web.

Cadangan SODP :

- Gunakan pertanyaan SQL untuk menjalankan kemas kini kelompok terhadap ralat dan bukannya membetulkan setiap isu secara manual.

- Tiru Googlebot, melalui tetapan perayapan carian, untuk mengelakkan disekat daripada penyedia pengehosan dan untuk mengenal pasti serta membetulkan semua isu teknikal dengan betul.

- Nyahpepijat halaman yang hilang daripada perayapan menggunakan panduan hebat ini daripada Screaming Frog . 17

9. Parameter URL

Parameter URL — bahagian alamat web yang mengikuti "?" — digunakan pada halaman atas pelbagai sebab, termasuk penapisan, penomboran halaman dan carian.

Walaupun ini boleh meningkatkan pengalaman pengguna, ia juga boleh menyebabkan masalah perayapan apabila kedua-dua URL asas dan URL yang mempunyai parameter mengembalikan kandungan yang sama. Contohnya ialah “http://mysite.com” dan “http://mysite.com?id=3” yang mengembalikan halaman yang sama.

Parameter membolehkan sesebuah laman web mempunyai bilangan pautan yang hampir tidak terhad — seperti apabila pengguna boleh memilih hari, bulan dan tahun pada kalendar. Jika bot dibenarkan merayapi halaman ini, bajet perayapan akan digunakan tanpa perlu.

Cadangan SODP :

- Gunakan peraturan robots.txt. Contohnya, tentukan tertib parameter dalam arahan benarkan.

- Gunakan hreflang untuk menentukan variasi bahasa kandungan.

Ringkasan Mitos dan Fakta Googlebot

Terdapat beberapa salah tanggapan mengenai kuasa dan skop Googlebot.

Berikut adalah lima yang telah kami terokai:

1. Googlebot Merayapi Laman Sesawang Secara Berselang-seli

Googlebot sebenarnya merayapi laman web dengan agak kerap dan, dalam beberapa situasi, malah setiap hari. Walau bagaimanapun, kekerapan ditentukan oleh kualiti, kebaharuan, kerelevanan dan populariti laman web tersebut.

Seperti yang dinyatakan di atas, Google Search Console (GSC) boleh digunakan untuk meminta perayapan.

2. Googlebot Membuat Keputusan Mengenai Kedudukan Laman Web

Walaupun dahulunya ini betul, Google kini menganggapnya sebagai bahagian berasingan daripada proses perayapan, indeks dan kedudukan, menurut Martin Splitt , Penganalisis Trend WebMaster di Google. 18

Walau bagaimanapun, penting juga untuk diingat bahawa kandungan, peta laman, bilangan halaman, pautan, URL dan sebagainya sesebuah laman web merupakan faktor dalam menentukan kedudukannya.

Pada dasarnya, pilihan SEO yang bijak oleh penerbit boleh membawa kepada kedudukan yang kukuh dalam SERP.

3. Googlebot Menyerang Bahagian Persendirian Laman Web

Bot tersebut tidak mempunyai konsep "kandungan peribadi" dan hanya ditugaskan untuk mengindeks laman web melainkan diarahkan oleh pemilik laman web untuk melakukan sebaliknya.

Sesetengah laman web boleh kekal tidak diindeks selagi langkah-langkah yang diperlukan dalam GSC diambil untuk menyekat akses.

4. Aktiviti Googlebot Boleh Memberi Tekanan pada Kebolehkerjaan Tapak

Proses Googlebot mempunyai batasannya kerana batasan sumber Google dan kerana Google tidak mahu mengganggu sesebuah laman web.

Splitt berkata: “Kami merangkak sedikit, dan kemudian pada dasarnya meningkatkannya. Dan apabila kami mula melihat ralat, kami menurunkannya sedikit.”15

GSC boleh melambatkan perayapan dan memandangkan sesetengah tapak mungkin mempunyai beberapa ratus ribu halaman, Googlebot memecahkan perayapannya ke atas beberapa lawatan.

5. Googlebot ialah Satu-satunya Bot yang Patut Dibimbangkan

Walaupun Googlebot merupakan perayap utama dunia, tidak semua bot milik Google. Enjin carian lain merayapi web, manakala bot yang menumpukan pada analitik serta data dan keselamatan jenama juga aktif.

Pada masa yang sama, pihak yang tidak bertanggungjawab sedang mereka bentuk perisian yang semakin canggih untuk terlibat dalam penipuan iklan , mencuri kandungan, menyiarkan spam dan banyak lagi. 19

Fikiran Akhir

Adalah penting untuk diingat bahawa pengoptimuman bajet perayapan dan pengalaman pengguna yang berjaya boleh diuruskan tanpa menjejaskan yang lain

Memeriksa kesihatan bajet perayapan tapak harus menjadi elemen dalam semua program penyelenggaraan pemilik laman web, dengan kekerapan pemeriksaan ini bergantung pada saiz dan sifat laman web itu sendiri.

Pengemasan teknikal — seperti membetulkan pautan yang rosak, halaman yang tidak berfungsi , kandungan yang digandakan, URL yang ditulis dengan salah dan peta laman lama yang sarat dengan ralat — juga penting.

- Pengurusan Bajet Rangkaian Untuk Tapak Besar | Pusat Carian Google | Dokumentasi

- Apakah Maksud Bajet Rangkaian untuk Googlebot | Blog Pusat Carian Google

- Kurangkan Kadar Perayapan Googlebot | Pusat Carian Google | Dokumentasi

- Tukar kadar perayapan Googlebot – Bantuan Konsol Carian

- Pengoptimuman Bajet Rangkai untuk Penerbit | Keadaan Penerbitan Digital

- Konsol Carian Google

- Laporan Liputan Indeks – Bantuan Konsol Carian

- Alat Pemeriksaan URL – Bantuan Konsol Carian

- Laporan Statistik Perayapan – Bantuan Konsol Carian

- Gabungkan URL Pendua dengan Canonicals | Pusat Carian Google | Dokumentasi

- Pemaparan di Web | Pembangun Google

- Stape.io

- Laporan Core Web Vitals – Bantuan Konsol Carian

- Cat Berisi Terbesar (LCP)

- Kelewatan Input Pertama (FID)

- Anjakan Susun Atur Kumulatif (CLS)

- Cara Menyahpepijat Halaman Hilang Dalam Crawl – Screaming Frog

- Googlebot: Pemusnahan Mitos SEO

- Penipuan Iklan: Semua Yang Anda Perlu Tahu | Publift